Content from Antes de comenzar

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 30 minutos

¿Qué es Python?

Hoja de ruta

Preguntas

- ¿Qué es Python y por qué debería aprenderlo?

Objetivos

- Describir el propósito del editor, consola, ayuda, el panel explorador de variables y el panel explorador de archivos de Spyder.

- Organizar los archivos y directorios para un conjunto de análisis como proyecto de Python, y entender el propósito del directorio de trabajo.

- Saber donde buscar ayuda.

- Demostrar como proporcionar suficiente información para solucionar problemas junto con la comunidad de usuarios de Python.

Python es un lenguaje de programación de tipo general que soporta un desarrollo rápido de aplicaciones de análisis de datos. La palabra “Python” es usada para referirse tanto al lenguaje de programación, como a la herramienta que ejecuta los scripts escritos en el lenguaje “Python”.

Sus principales ventajas son:

- Es gratis

- De código abierto

- Disponible para todas las plataformas más importantes (macOS, Linux, Windows)

- Es mantenido por la Python Software Foundation

- Soporta múltiples paradigmas de programación

- Tiene una gran comunidad

- Tiene un rico ecosistema de paquetes de terceros

Entonces, ¿por qué necesitas Python para el análisis de datos?

Fácil de aprender

Python es más fácil de aprender que otros lenguajes de programación. Esto es importante debido a que al tener barreras de aprendizaje más bajas es más fácil para los nuevos miembros de la comunidad ponerse al día.

Reproducibilidad

La reproducibilidad es la habilidad de obtener los mismos resultados usando los mismos datos y análisis.

Un análisis de datos escrito en un script de Python puede ser reproducido en cualquier plataforma. Es más, si recolectas más datos o corriges datos existentes, ¡puedes volver a ejecutar los análisis de manera rápida y sencilla!

Cada vez más revistas científicas y agencias de financiación esperan que los análisis sean reproducibles, por lo tanto, saber Python te dará una ventaja sobre estos requisitos.

Versatilidad

Python es un lenguaje versátil que se integra con varias aplicaciones existentes para permitir hacer cosas sorprendentes. Por ejemplo, uno puede usar Python para generar manuscritos, de tal forma que si necesitas actualizar tus datos, procedimientos de análisis, o cambiar algo más, puedes volver a generar todas las figuras rápidamente y tu manuscrito se actualizará automáticamente.

Python puede leer archivos de texto, conectarse a bases de datos, y a muchos otros formatos de datos, ya sea en tu computadora o en la web.

Interdisciplinario y extensible

Python provee un marco de trabajo que permite que cualquier persona combine enfoques de diferentes disciplinas de investigación (y no solo de investigación) para ajustarse mejor a tus necesidades de análisis.

Python tiene una comunidad grande y amable

Miles de personas usan Python diariamente. Muchos de ellos están dispuestos a ayudarte a través de listas de correo y sitios web, tales como Stack Overflow y el portal de la comunidad de Anaconda.

Conociendo a Anaconda

La distribución de Python Anaconda incluye montones de paquetes populares como la consola Ipython, Jupyter Notebook, y Spyder IDE. Échale un vistazo al Navegador Anaconda. Puedes ejecutar programas desde el Navegador o usar la línea de comando.

Jupyter Notebook es una aplicación web de código abierto que permite crear y compartir documentos que permiten crear de manera sencilla documentos que combinan código, gráficos y texto narrativo.

Spyder es un Entorno de Desarrollo Integrado (IDE por sus siglas en inglés) que permiten escribir scripts de Python e interactuar con el software de Python desde una interfaz única.

Anaconda también viene con un gestor de paquetes llamado conda, el cual hace que sea fácil instalar y actualizar paquetes adicionales.

Proyecto de Investigación: Buenas Prácticas

Es una buena idea guardar los grupos de datos relacionados, análisis, y texto en una única carpeta. Por lo tanto, todos los scripts y archivos de texto dentro de esta carpeta pueden usar paths relativos hacia los archivos de datos. Trabajar de esta manera hace que sea mucho más fácil mover tu proyecto y compartirlo con otras personas.

Organizando tu directorio de trabajo

Usar una estructura de carpetas de forma consistente a través de tus proyectos te ayudará a mantener las cosas organizadas, y hará que sea fácil encontrar/archivar cosas en el futuro. Esto puede ser especialmente útil cuando tienes múltiples proyectos. En general, podrías llegar a querer crear directorios separados para tus scripts, datos, y documentos.

data/: Usa esta carpeta para guardar tus datos crudos. Por el bien de la transparencia y procedencia, siempre deberías guardar una copia de tus datos crudos. Si necesitas limpiar tus datos, hazlo de manera programática (i.e., con scripts) y asegúrate de separar los datos limpios de los crudos. Por ejemplo, puedes guardar los datos crudos en./data/raw/y los limpios en./data/clean/.documents/: Usa esta carpeta para guardar esquemas, borradores, y otro texto.scripts/: Usa esta carpeta para guardar tus scripts (de Python) para limpieza de datos, análisis y generación de gráficos que uses en este proyecto en particular.

Puede que tengas que crear directorios adicionales dependiendo de las

necesidades de tu proyecto, pero los que nombramos deberían ser el eje

del directorio. Para este workshop, vamos a necesitar una carpeta

data/ para almacenar nuestros datos crudos, y luego vamos a

tener que crear la carpeta data_output/ cuando aprendamos

como exportar datos como archivos CSV.

¿Qué es Programación y Codificación?

Programación es el proceso de escribir “programas” que una computadora pueda ejecutar produciendo algún resultado (útil). La programación es un proceso de múltiples pasos que implican:

- Identificar los aspectos de un problema de la vida real que pueda ser resuelto computacionalmente.

- Identificar la (mejor) solución computacional.

- Implementar la solución en un lenguaje de programación específico.

- Testear, validar, y ajustar la solución implementada.

Mientras que “Programar” se refiere a todos los pasos nombrados, “Codificación” se refiere solo al paso 3: “Implementar la solución en un lenguaje de programación específico”.

Si trabajas con Jupyter notebook:

Puedes tipear código de Python en una celda de código y luego ejecutarla presionando Shift+Enter.

El output se imprimirá directamente bajo la celda de input. Se puede

reconocer a una celda de código mediante el In[ ]: al

principio de la celda y a una celda de output por el

Out[ ]:.

Presionar el botón + en la barra de menú agregará una nueva celda.

Todos tus comandos tal como los outputs serán guardados con el notebook.

Si trabajas con Spyder:

Puedes usar tanto la consola o un archivo de script (archivos de texto plano que contienen tu código). El panel de consola (el panel abajo a la derecha, en Spyder) es el lugar donde los comandos escritos en el lenguaje de programación Python pueden ser tipeados y ejecutados inmediatamente por la computadora. También es donde se mostrarán los resultados. Puedes ejecutar los comandos directamente en la consola presionando Enter, pero serán “perdidos” cuando cierres la sesión. Spyder usa la consola IPython por defecto.

Debido a que queremos que nuestro código y flujo de trabajo sea reproducible, es mejor tipear los comandos en el editor de scripts, y guardarlos como un script. De esta manera, hay un registro completo de lo que hicimos, y cualquiera (¡incluyendo nuestros yo futuros!) pueden reproducir los resultados en su computadora de forma sencilla.

Spyder permite ejecutar comandos directamente desde el editor de scripts usando los botones de ejecución en la parte superior.

Para ejectuar el script entero haz clic en Run file o presiona F5. Para ejecutar la línea actual haz clic en Run selection or current line o presiona F9, otros botones de ejecución permiten ejecutar celdas de scripts o activar el modo debug. Cuando se usa F9, el comando en la línea actual del script (indicada por el cursor) o todos los comandos en el actual texto seleccionado serán enviados a la consola y ejecutados.

En algún punto en tu análisis podrías llegar a desear comprobar el contenido de una variable o la estructura de un objeto, sin necesariamente guardar un registro en tu script. Puedes tipear estos comandos y ejecutarlos directamente en la consola. Spyder provee los atajos Ctrl+Shift+E y Ctrl+Shift+I que te permitirán “saltar” entre el panel de scripts y el de la consola.

Si Python está listo para aceptar comandos, la consola IPython

muestra un aviso In [..]: con el número de línea actual en

la consola entre corchetes []. Si recibe un comando

(mediante tipeo, copiando y pegando o enviado desde el editor de

scripts) Python lo va a ejecutar, mostrar los resultados en la celda

Out [..]:, y luego volver con un nuevo aviso

In [..]: a la espera de nuevos comandos.

Si Python todavía está esperando a que ingreses mas datos debido a

que todavía no has terminado, la consola mostrará un aviso

...:. Significa que no has terminado de ingresar un comando

completo.

Esto es debido a que no has tipeado un paréntesis de cierre

(), ], o }) o comillas. Cuando

sucede esto, y pensaste que habías terminado de tipear tu comando, haz

clic dentro de la ventana de la consola y presiona Esc; esto

cancelará el comando incompleto y te retornará al aviso

In [..]:.

¿Cómo aprender más luego del taller?

El material que cubrimos durante este taller te dará una prueba inicial de cómo puede usarse Python para analizar datos de tu propia investigación. Sin embargo, todavía necesitarás aprender más sobre operaciones más avanzadas tal como la limpieza de tu dataset, usar métodos estadísticos, o crear gráficos bonitos. La mejor manera de hacerse competente y eficiente en Python, así como con cualquier otra herramienta, es empleándola para abordar tus propias preguntas de investigación. Como principiante, puede sentirse desalentador tener que escribir un script desde el inicio, y dado que muchas personas comparten su código en la web, modificar código existente para adaptarlo a tus propósitos puede hacer que comenzar sea más fácil.

Buscando ayuda

- revisa el menú Ayuda

- tipea

help() - tipea

?objectohelp(object)para obtener información sobre un objeto - Documentación de Python

Finalmente, una búsqueda genérica en Google o internet de “Python tarea_a_buscar” usualmente te enviará a la documentación del módulo apropiado o a un foro dónde alguien más ya ha hecho la misma pregunta.

Estoy atorada… tengo un mensaje de error que no entiendo. Empieza por googlear el mensaje de error. Sin embargo, esto no siempre funciona muy bien debido a que a veces, los desarrolladores emplean los mensajes de error provistos por Python. Por ello terminas con mensajes de error genéricos que podrían no llegar a ser de ayuda para diagnosticar un problema (Ej.: “subscript out of bounds”). Si el mensaje es muy genérico, quizás deberías incluir en tu consulta el nombre de la función o paquete que estés usando.

Sin embargo, deberías chequear Stack Overflow. Buscar usando la etiqueta [python]. La mayoría de las preguntas ya han sido respondidas, el desafío es usar la combinación de palabras apropiadas en la búsqueda para encontrar las respuestas: http://stackoverflow.com/questions/tagged/python.

Pidiendo ayuda

La clave para recibir ayuda de alguien es que ellos entiendan rápidamente tu problema. Deberías hacer que sea lo más fácil posible identificar dónde podría estar el inconveniente.

Trata de usar las palabras correctas para describir el problema. Por ejemplo, un paquete no es lo mismo que una biblioteca. La mayoría de las personas entenderán lo que quieres decir, pero otras tienen fuertes sentimientos sobre la diferencia en el significado. El punto clave es que puede hacer que las cosas sean confusas para las personas que tratan de ayudarte. Trata de ser tan precisa como sea posible cuando describes tu problema.

Si es posible, trata de resumir lo que no funciona en un ejemplo simple y reproducible. Si puedes reproducir el problema usando una pequeña cantidad de datos en lugar de tus 50.000 filas y 10.000 columnas, proporciona el dataset pequeño con la descripción de tu problema. Cuando sea apropiado, trata de generalizar lo que estas haciendo, así incluso las personas que no están familiarizadas con tu campo de estudio podrán entender tu pregunta. Por ejemplo, en lugar de usar un subconjunto de tu datase real, crea uno pequeño (3 columnas, 5 filas) y genérico.

¿Dónde pedir ayuda?

- A la persona sentada junto a tu durante el taller. No dudes en hablar con tu vecina durante el taller, compara tus respuestas, pide ayuda. También podrías estar interesada en organizar reuniones regularmente luego del taller para seguir aprendiendo una de otra.

- Tus amigables colegas: si conoces a alguien con mas experiencia que tu, ellas podrían estar capacitadas y dispuestas a ayudarte.

- Stack Overflow: si tu pregunta no ha sido contestada con anterioridad y además está bien planteada, hay chances de que obtengas una respuesta en 5 minutos. Recuerda seguir los lineamientos de cómo preguntar correctamente.

- Listas de correo de Python

Más recursos

PyPI - the Python Package Index

The Hitchhiker’s Guide to Python

- Python es un lenguaje de programación de código libre y plataforma independiente.

- SciPy es un ecosistema para Python que provee las herramientas necesarias para la computación científica.

- Jupyter Notebook y la Spyder IDE son excelentes herramientas para escribir código e interactuar con Python. Con su gran comunidad es fácil encontrar ayuda en internet.

Content from Breve introducción a la Programación en Python

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 0 minutos

Intérprete

Hoja de ruta

Preguntas

- ¿Qué es Python?

- ¿Porqué deberías aprender Python?

Objetivos

- Describir las ventajas de usar programación vs. completar tareas repetitivas a mano.

- Definir los tipos de datos en Python: cadenas, enteros, y números de punto flotante.

- Realizar operaciones matemáticas en Python utilizando operadores básicos.

- Dentro del contexto de Python definir: listas, tuplas, y diccionarios.

Python es un lenguaje interpretado que puede ser usado de dos formas:

- Modo “Interactivo”: cuando lo usas como una “calculadora avanzada”

ejecutando un comando a la vez. Para iniciar Python en este modo,

simplemente ejecuta

pythonen la línea de comandos:

SALIDA

Python 3.5.1 (default, Oct 23 2015, 18:05:06)

[GCC 4.8.3] on linux2

Type "help", "copyright", "credits" or "license" for more information.

>>>Los res símbolos de mayor que >>> forman un

indicador interactivo en Python, que significa que está esperando tu

entrada de datos.

SALIDA

4SALIDA

Hello World- Modo “Script”: cuando ejecutas una serie de “comandos” guardados en

un archivo de texto, generalmente con una extensión

.pydespués del nombre de tu archivo:

SALIDA

Hello WorldIntroducción a los tipos de datos incorporados en Python

Strings, integers, and floats

Una de las cosas más básicas que podemos hacer en Python es asignar valores a las variables:

PYTHON

text = "Data Carpentry" # Un ejemplo de string

number = 42 # Un ejemplo de integer

pi_value = 3.1415 # Un ejemplo de floatAquí hemos asignado datos a las variables

text,number y pi_value,

utilizando el operador de asignación =. Para revisar el

valor de una variable, nosotros podemos escribir el nombre de la

variable en el intérprete y presionar Return:

SALIDA

"Data Carpentry"Todo en Python tiene un tipo. Para obtener el tipo de algo, podemos

pasarlo a la función type:

SALIDA

<class 'str'>SALIDA

<class 'int'>SALIDA

<class 'float'>La variable text es de tipo ‘str’, abreviatura de

string o cadena de caracteres. Las cadenas almacenan

secuencias de caracteres, que pueden ser letras, números, puntuación o

formas más exóticas de texto (¡incluso emoji!).

También podemos ver el valor de algo usando otra función incorporada,

print:

SALIDA

Data CarpentrySALIDA

11Esto puede parecer redundante, pero de hecho es la única forma de mostrar resultados en un script:

example.py

PYTHON

# En un archivo script de Python

# los comentarios en Python inician con #

# Las siguientes líneas asignan la cadena "Data Carpentry" a la variable "text".

text = "Data Carpentry"

# ¡La siguiente línea no hace nada!

text

# La siguiente línea usa la función print para imprimir el valor asignado a "text"

print(text)Ejecutando el script

SALIDA

Data CarpentryNota que “Data Carpentry” se imprime una vez.

Sugerencia: print y type

son funciones incorporadas en Python. Más adelante en esta lección,

veremos métodos y funciones definidas por el usuario. La documentación

de Python es excelente para darte una referencia sobre las diferencias

entre ellos.

Operadores

Podemos realizar cálculos matemáticos en Python usando los operadores

básicos +, -, /, *, %:

SALIDA

4SALIDA

42SALIDA

65536SALIDA

3También podemos utilizar operadores de comparación y lógicos:

<,>, ==,! =, <=,> = y declaraciones de

identidad como and, or, not. El tipo de datos devuelto por

estos operadres es llamado boolean y retorna

verdadero o falso, como ves a continuación.

SALIDA

FalseSALIDA

TrueSALIDA

TrueSALIDA

FalseSecuencias: Listas y Tuplas

Listas

list (o listas) son una estructura de datos común para almacenar una secuencia ordenada de elementos. Se puede acceder a cada elemento mediante un índice. Ten en cuenta que en Python, los índices comienzan con 0 en lugar de 1:

SALIDA

1Se puede usar un bucle for para acceder a los elementos

de una lista u otras estructuras de datos de Python, uno a la vez:

SALIDA

1

2

3Usar sangría es muy importante en Python. Ten en

cuenta que la segunda línea en el ejemplo de arriba está sangrada (o

indentada). Al igual que los tres >>> son un

indicador interactivo en Python, los tres puntos ... son

indicadores de líneas multiples en Python. Esta es la manera en que

Python marca un bloque de código. [Nota: no tienes que escribir

>>> o ....]

Para agregar elementos al final de una lista, podemos usar el método

append. Los métodos son una forma de interactuar con un

objeto (una lista, por ejemplo). Podemos invocar un método usando el

punto . seguido del nombre del método y una lista de

argumentos entre paréntesis. Veamos un ejemplo usando

append:

SALIDA

[1, 2, 3, 4]Para averiguar qué métodos están disponibles para un objeto, podemos

usar el comando incorporado help:

SALIDA

help(numbers)

Help on list object:

class list(object)

| list() -> new empty list

| list(iterable) -> new list initialized from iterable's items

...Tuplas

Una tupla tuple es similar a una lista en que es una

secuencia ordenada de elementos. Sin embargo, las tuplas no se pueden

cambiar una vez creadas (son “inmutables”). Las tuplas se crean

colocando valores separados por comas dentro de los paréntesis

().

PYTHON

# Las tuplas usan paréntesis

a_tuple = (1, 2, 3)

another_tuple = ('blue', 'green', 'red')

# Nota: las listas usan corchetes cuadrados

a_list = [1, 2, 3]Tuplas vs. Listas

- ¿Qué sucede cuando ejecutas

a_list[1] = 5? - ¿Qué sucede cuando ejecutas

a_tuple[2] = 5? - ¿Qué te dice

type(a_tuple)sobrea_tuple?

Diccionarios

Un diccionario dictionary es un contenedor que almacena pares de objetos - claves y valores.

SALIDA

1Los diccionarios funcionan como listas, excepto que se crea el índice utilizando claves keys. Puedes pensar en una clave como un nombre o un identificador único para un conjunto de valores en el diccionario. Las claves sólo pueden tener tipos particulares, tienen que ser “hashable”. Las cadenas y los tipos numéricos son aceptables, pero las listas no lo son.

SALIDA

'one'SALIDA

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

TypeError: unhashable type: 'list'En Python, un “Traceback” es un bloque de error de varias líneas impreso para el usuario.

Para agregar un elemento al diccionario, asignamos un valor a una nueva clave:

SALIDA

{1: 'one', 2: 'two', 3: 'three'}Usar bucles for con diccionarios es un poco más

complicado. Podemos hacer esto de dos maneras:

SALIDA

1 -> one

2 -> two

3 -> threeo

SALIDA

1 -> one

2 -> two

3 -> threeCambiando diccionarios

- Primero, imprime el valor de

revdel diccionario en la pantalla. - Reasigna el segundo valor (parar el par clave: valor) para que ya no lea “dos” sino “manzana”.

- Imprime el valor de

reven la pantalla nuevamente y ve si el valor ha cambiado.

Es importante tener en cuenta que los diccionarios están “desordenados” y no recuerdan la secuencia de sus elementos (es decir, el orden en el que los pares clave: valor fueron añadidos al diccionario). Debido a esto, el orden en que los elementos son devuelto en los bucles sobre los diccionarios, puede aparecer al azar e incluso puede cambiar con el tiempo.

Funciones

Definir una sección de código como una función en Python se hace

utilizando la palabra clave def. Por ejemplo, una función

que tome dos argumentos y devuelve su suma puede ser definida como:

SALIDA

42- Python es un lenguaje interpretado que puede ser usado interactivamente (ejecutando un comando a la vez) o en modo scripting (ejecutando una serie de comandos guardados en un archivo).

- Se puede asignar un valor a una variable en Python. Esas variables pueden ser de varios tipos, tales como cadenas, y números: enteros, de punto flotante y complejos.

- Las listas y las tuplas son similares en el sentido de que son listas ordenadas de elementos; difieren en que una tupla es inmutable (sus elementos no pueden ser modificados).

- Los diccionarios son estructuras de datos desordenadas que proporcionan mapeos entre claves y valores.

Content from Comenzando con datos

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 60 minutos

Trabajando con Pandas DataFrames en Python

Hoja de ruta

Preguntas

- ¿Cómo importar datos en Python?

- ¿Qué es Pandas?

- ¿Por qué debería de usar Pandas para trabajar con datos?

Objetivos

- Explorar el directorio del taller y descargar el dataset.

- Explicar qué es una biblioteca y para qué se usa.

- Describir qué es, Pandas, la Biblioteca de Análisis de Datos de Python.

- Cargar Pandas, la biblioteca de Análisis de Datos de Python.

- Usar

read_csvpara leer datos tabulares en Python. - Describir qué es un DataFrame en Python.

- Acceder y resumir datos guardados en un DataFrame.

- Definir la indexación y su relación con las estructuras de datos.

- Ejecutar operaciones matemáticas básicas y calcular estadísticas descriptivas sobre datos dentro de un Pandas Dataframe.

- Crear gráficos simples.

Podemos automatizar el proceso de manipular datos con Python. Vale la pena pasar tiempo escribiendo el código que haga estas tareas ya que una vez que se escribió, lo podemos usar una y otra vez en distintos conjuntos de datos que usen un formato similar. Esto hace a nuestros métodos fácilmente reproducibles. También resulta fácil compartir nuestro código con nuestros colegas y ellos pueden replicar el mismo análisis.

Comenzando en el mismo lugar

Para que la lección salga de la mejor manera posible, vamos a asegurarnos que todos estemos en el mismo directorio. Esto debería ayudarnos a evitar inconvenientes con los nombres de los directorios y los archivos. Navega al directorio del taller. Si tu estás trabajando en IPython Notebook asegurate de iniciar tu notebook en el directorio del taller.

Un comentario al margen es que hay bibliotecas de Python, como OS Library, las cuales pueden trabajar con la estructra de directorios, sin emebargo este no es nuestro objetivo el día de hoy.

Nuestros datos

Para esta lección, usaremos los datos de “Portal Teaching” que son subconjunto de los datos estudiados por Ernst et al. Long-term monitoring and experimental manipulation of a Chihuahuan Desert ecosystem near Portal, Arizona, USA.

Usaremos los datos de Portal

Project Teaching Database. Esta sección usa el archivo

surveys.csv el cual puede ser descargado desde: https://ndownloader.figshare.com/files/2292172

Vamos a estudiar la especie y el peso de los animales capturados en

sitios dentro de nuestra área de estudio. El conjunto de datos esta

guardado en un archivo .csv: cada línea tiene información

sobre un solo animal y las columnas representan:

| Columna | Descripción |

|---|---|

| record_id | identificador único de la observación |

| month | mes de observación |

| day | día de la observación |

| year | año de la observación |

| plot_id | ID de un sitio en particular |

| species_id | código de dos letras |

| sex | sexo del animal (“M”, “F”) |

| hindfoot_length | tamaño de pata en mm |

| weight | peso del animal en gramos |

Las primeras líneas de nuestro archivo se ven de la siguiente manera:

SALIDA

record_id,month,day,year,plot_id,species_id,sex,hindfoot_length,weight

1,7,16,1977,2,NL,M,32,

2,7,16,1977,3,NL,M,33,

3,7,16,1977,2,DM,F,37,

4,7,16,1977,7,DM,M,36,

5,7,16,1977,3,DM,M,35,

6,7,16,1977,1,PF,M,14,

7,7,16,1977,2,PE,F,,

8,7,16,1977,1,DM,M,37,

9,7,16,1977,1,DM,F,34,Acerca de las bibliotecas

Una biblioteca en Python contiene un conjunto de herramientas (llamadas funciones) que hacen tareas en nuestros datos. Importar una biblioteca es como traer un la pieza de laboratorio de nuestro locker y montarla en nuestra mesa de trabajo para usarla en nuestro proyecto. Una vez que la bilioteca está instalada, puede ser usada y llamada para hacer muchas tareas.

Pandas en Python

Una de las mejores opciones para trabajar con datos tabulares en Python es usar la Python Data Analysis Library (alias Pandas). La biblioteca Pandas provee estructuras de datos, genera gráficos de alta calidad con matplotlib y se integra de buena forma con otras bibliotecas que usan arrays de NumPy (la cual es otra biblioteca de Python).

Python no carga todas las bibliotecas disponibles por default. Se

tiene que usar el enunciado import en nuestro código para

usar las funciones de la biblioteca. Para importar una biblioteca se usa

la sintaxis import nombreDeLaBiblioteca. Si además le

queremos poner un sobrenombre para acortar los comandos, se puede

agregar as sobrenombreAUsar. Un ejemplo es importar la

biblioteca pandas usando su sobrenombre común pd como está

aquí abajo.

Cada vez que llamemos a una función que está en la biblioteca, se usa

la sintaxis NombreDeLaBiblioteca.NombreDeLaFuncion. Agregar

el nombre de la biblioteca con un . antes del nombre de la

función le indica a Python donde encontrar la función. En el ejemplo

anterior hemos importado a Pandas como pd. Esto significa

que no vamos a tener que escribir pandas cada vez que

llamemos a una función de Pandas y solo lo hagamos con su

sobrenombre.

Leyendo datos en CSV usando Pandas

Empezaremos encontrando y leyendo los datos del censo que están en

formato CSV. CSV son las siglas para Comma-Separated Values,

valores separados por coma, y es una manera común de guardar datos.

Otros símbolos pueden ser usados, te puedes encontrar valores separados

por tabuladores, por punto y coma o por espacios en blanco. Es fácil

remplazar un separador por otro, para usar tu aplicación. La primera

línea del archivo generalmente contiene los encabezados que dicen que

hay en cada columna. CSV (y otros separadores) hacen fácil compartir los

datos y pueden ser importados y exportados desde distintos programas,

incluyendo Microsoft Excel. Para más detalles sobre los archivos CSV, ve

la lección Organización

de datos en hojas de cálculo. Podemos usar la función de Pandas

read_csvpara abrir el archivo directamente en un DataFrame.

Entonces, ¿qué es un DataFrame?

Un DataFrame es una estructura de datos con dos

dimensiones en la cual se puede guardar datos de distintos tipos (como

caractéres, enteros, valores de punto flotante, factores y más) en

columnas. Es similar a una hoja de cálculo o una tabla de SQL o el

data.frame de R. Un DataFrame siempre

tiene un índice (con inicio en 0). El índice refiere a la posición de un

elemento en la estructura de datos.

PYTHON

# Observa que se usa pd.read_csv debido a que importamos a pandas como pd

pd.read_csv("data/surveys.csv")El comando anterior lleva a la siguiente salida:

SALIDA

record_id month day year plot_id species_id sex hindfoot_length weight

0 1 7 16 1977 2 NL M 32 NaN

1 2 7 16 1977 3 NL M 33 NaN

2 3 7 16 1977 2 DM F 37 NaN

3 4 7 16 1977 7 DM M 36 NaN

4 5 7 16 1977 3 DM M 35 NaN

...

35544 35545 12 31 2002 15 AH NaN NaN NaN

35545 35546 12 31 2002 15 AH NaN NaN NaN

35546 35547 12 31 2002 10 RM F 15 14

35547 35548 12 31 2002 7 DO M 36 51

35548 35549 12 31 2002 5 NaN NaN NaN NaN

[35549 rows x 9 columns]Podemos ver que se leyeron 35,549 líneas. Cada una de los líneas

tiene 9 columnas. La primera columna es el índice del DataFrame. El

índice es usado para identificar la posición de los datos, pero no es

una columna del DataFrame. Parace ser que la función

read_csvde Pandas leyó el archivo correctamente. Sin

embargo, no hemos salvado ningún dato en memoria por lo que no podemos

trabajar con estos. Necesitamos asignar el DataFrame a

una variable. Recuerda que una variable es el nombre para un valor, como

xo data. Podemos crear un nuevo objeto con el

nombre de la variable y le asignamos un valor usando =.

Llamemos los datos del censo importados surveys_df:

Notemos que cuando asignamos los datos importado a un

DataFrame a una variable, Python no produce ninguna

salida a pantalla. Podemos ver el contenido de surveys_df

escribiendo el nombre en la línea de comando de Python.t.

el cual imprime los contenidos como anteriormente.

Nota: si la salida es más ancha que la pantalla de teminal al imprimirlo se verá algo distinto conforme el gran conjunto de datos pasa. Se podría ver simplemente la última columna de los datos:

SALIDA

17 NaN

18 NaN

19 NaN

20 NaN

21 NaN

22 NaN

23 NaN

24 NaN

25 NaN

26 NaN

27 NaN

28 NaN

29 NaN

... ...

35519 36.0

35520 48.0

35521 45.0

35522 44.0

35523 27.0

35524 26.0

35525 24.0

35526 43.0

35527 NaN

35528 25.0

35529 NaN

35530 NaN

35531 43.0

35532 48.0

35533 56.0

35534 53.0

35535 42.0

35536 46.0

35537 31.0

35538 68.0

35539 23.0

35540 31.0

35541 29.0

35542 34.0

35543 NaN

35544 NaN

35545 NaN

35546 14.0

35547 51.0

35548 NaN

[35549 rows x 9 columns]No temas, todos los datos están ahí, si tu navegas hacía arriba de tu terminal. Seleccionemos solo algunas de las líneas, esto hara más facil que la salida quepa en una terminal, se puede ver que Pandas formateo los datos de tal manera que quepan en la pantalla:

PYTHON

surveys_df.head() # The head() method displays the first several lines of a file. It

# is discussed below.SALIDA

record_id month day year plot_id species_id sex hindfoot_length \

5 6 7 16 1977 1 PF M 14.0

6 7 7 16 1977 2 PE F NaN

7 8 7 16 1977 1 DM M 37.0

8 9 7 16 1977 1 DM F 34.0

9 10 7 16 1977 6 PF F 20.0

weight

5 NaN

6 NaN

7 NaN

8 NaN

9 NaNExplorando los datos del censo de especies

Una vez más podemos usar la función type para ver que

cosa es surveys_df:is:

SALIDA

<class 'pandas.core.frame.DataFrame'>Como podíamos esperar, es un DataFrame (o, usando el

nombre completo por el cual Python usa internamente, un

pandas.core.frame.DataFrame).

¿Qué tipo de cosas surveys_df contiene? Los

DataFrame tienen un atributo llamado

dtypes que contesta esta pregunta:

SALIDA

record_id int64

month int64

day int64

year int64

plot_id int64

species_id object

sex object

hindfoot_length float64

weight float64

dtype: objectTodos los valores de una columna tienen el mismo tipo. Por ejemplo,

months tienen el tipo int64, el cual es un tipo de entero.

Las celdas en la columna de mes no pueden tener valores fraccionarios,

pero las columnas de weight y hindfoot_length

pueden, ya que son de tupo float64. El tipo

object no tiene un nombre muy útil, pero en ete caso

representa una palabra (como ‘M’ y ‘F’ en el caso del sexo).

En otra lección discutiremos sobre el significado de los distintos tipos.

Formas útiles de ver objetos DataFrame en Python

Hay distintas maneras de resumir y accesar a los datos guardados en un DataFrame, usando los atributos y métodos que proveé el objeto DataFrame.

Para accesar a un atributo, se usa el nombre del objeto

DataFrame seguido del nombre del atributo

df_object.attribute. Usando el DataFrame

surveys_df y el atributo columns, un índice de

todos los nombres de las columnas en el DataFrame puede

ser accesado con surveys_df.columns.

Métodos son llamados de la misma manera usando la sintáxis

df_object.method(). Como ejemplo,

surveys_df.head() obtiene las primeros líneas del

DataFrame surveys_df usando el

método head(). Con un método, podemos proporcionar

información extra en los padres para contreol su comportamiento.

Echemos un ojo a los datos usando este.

Reto - DataFrames

Usando nuestro DataFrame surveys_df,

ejecuta los atributos y métodos siguientes y observa que regresan.

surveys_df.columnssurveys_df.shapeToma nota de la salida deshape- ¿Qué formato tiene la salida del atributo que regresa la forma de un DataFrame?

Sugerencia: Más acerca de tuplas, aquí.

surveys_df.head()También ejecutasurveys_df.head(15)¿qué hace esto?surveys_df.tail()

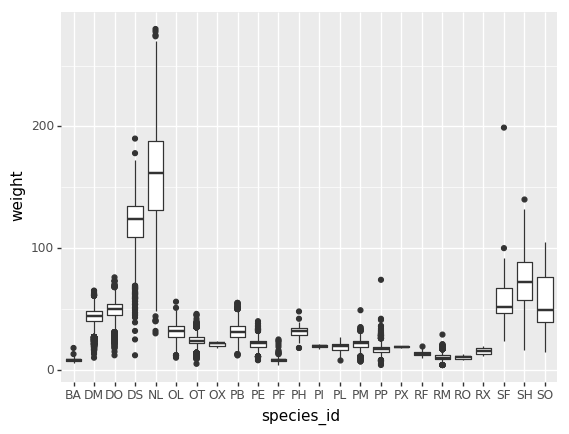

Calculando estadísticas de los datos en un DataFrame de Pandas

Hemos leídos los datos en Python. Ahora calculemos algunas estadísticas para entender un poco de los datos con los que estamos trabajando. Podríamos querer saber cuántos animales fueron colectados en cada sitio, o cuántos de cada especie fueron capturados. Podemos calcular estas estadísticas rápidamente usando grupos. Pero antes tenemos que saber como los queremos argupar.

Empezemos a explorar los datos:

lo que regresa:

SALIDA

Index(['record_id', 'month', 'day', 'year', 'plot_id', 'species_id', 'sex',

'hindfoot_length', 'weight'],

dtype='object')Obtengamos una lista de todas las especies. La función

pd.unique nos dice los distintos valores presentes en la

columnaspecies_id.

lo que regresa:

PYTHON

array(['NL', 'DM', 'PF', 'PE', 'DS', 'PP', 'SH', 'OT', 'DO', 'OX', 'SS',

'OL', 'RM', nan, 'SA', 'PM', 'AH', 'DX', 'AB', 'CB', 'CM', 'CQ',

'RF', 'PC', 'PG', 'PH', 'PU', 'CV', 'UR', 'UP', 'ZL', 'UL', 'CS',

'SC', 'BA', 'SF', 'RO', 'AS', 'SO', 'PI', 'ST', 'CU', 'SU', 'RX',

'PB', 'PL', 'PX', 'CT', 'US'], dtype=object)Reto - Estadísticas

Crear una lista de los IDs de los sitios (“plot_id”) que están en los datos del censo. Llamamemos a esta lista

site_names. ¿Cuántos sitios hay en los datos?, ¿cuántas especies hay en los datos?¿Cuál es la diferencia entre

len(site_names)ysurveys_df['plot_id'].nunique()?

Grupos en Pandas

En algunas ocasiones queremos calcular estadísticas de datos agrupados por subconjuntos o atributos de nuestros datos. Por ejemplo, si queremos calcular el promedio de peso de nuestros individuos por sitio.

Podemos calcular algunas estadísticas básica de todos los datos en una columna usando el siguiente comando:

nos devuelve la siguiente salida

PYTHON

count 32283.000000

mean 42.672428

std 36.631259

min 4.000000

25% 20.000000

50% 37.000000

75% 48.000000

max 280.000000

Name: weight, dtype: float64También podemos extraer una métrica en particular::

PYTHON

surveys_df['weight'].min()

surveys_df['weight'].max()

surveys_df['weight'].mean()

surveys_df['weight'].std()

surveys_df['weight'].count()Pero si nosotros queremos extraer información por una o más

variables, por ejemplo sexo, podemos usar el método

.groupby de Pandas. Una vez que creamos un

DataFrame groupby, podemos calcular estadísticas por el

grupo de nuestra elección.

La función describe de Pandas regresa

estadísticas descriptivas incluyendo: media, meadiana, máx, mín, std y

conteos para una columna en particular de los datos. La función

describe solo regresa los valores de estas estadísticas

para las columnas numéricas.

PYTHON

# Estadísticas para todas las columnas numéricas por sexo

grouped_data.describe()

# Regresa la media de cada columna numérica por sexo

grouped_data.mean()grouped_data.mean() SALIDA:

PYTHON

record_id month day year plot_id \

sex

F 18036.412046 6.583047 16.007138 1990.644997 11.440854

M 17754.835601 6.392668 16.184286 1990.480401 11.098282

hindfoot_length weight

sex

F 28.836780 42.170555

M 29.709578 42.995379El comando groupby es muy potente y no permite

rápidamente generar estadísticas descriptivas.

Reto - Descripción de datos

- ¿Cuántos individuos son hembras

Fy cuántos son machosM? - Qué pasa cuando agrupas sobre dos columnas usando el siguiente enunciado y después tomas los valores medios:

grouped_data2 = surveys_df.groupby(['plot_id','sex'])grouped_data2.mean()

- Calcula las estadísticas descriptivas del peso para cada sitio.

Sugerencia: puedes usar la siguiente sintaxis para solo crear las

estadísticas para una columna de tus datos

by_site['weight'].describe()

Un pedaxo de la salida para el reto 3 se ve así:

SALIDA

site

1 count 1903.000000

mean 51.822911

std 38.176670

min 4.000000

25% 30.000000

50% 44.000000

75% 53.000000

max 231.000000

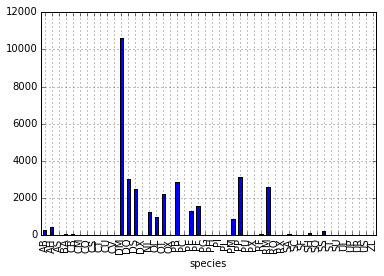

...Creando estadísticas de conteos rapidamente con Pandas

Ahora contemos el número de muestras de cada especie. Podemos hacer

esto de dsitintas maneras, pero usaremos groupby combinada

con el método count().

PYTHON

# Cuenta el número de muestras por especie

species_counts = surveys_df.groupby('species_id')['record_id'].count()

print(species_counts)O, también podemos contar las líneas que tienen la especie “DO”:

Reto - Haciendo una lista

¿Qué otra manera hay de crear una lista de especies y asociarle

count de las muestras de los datos? Sugerencia: puedes

hacer ejecutar las funciones count, min, etc.

en un DataFrame groupby de la misma manera de la que se

hace en un DataFrame

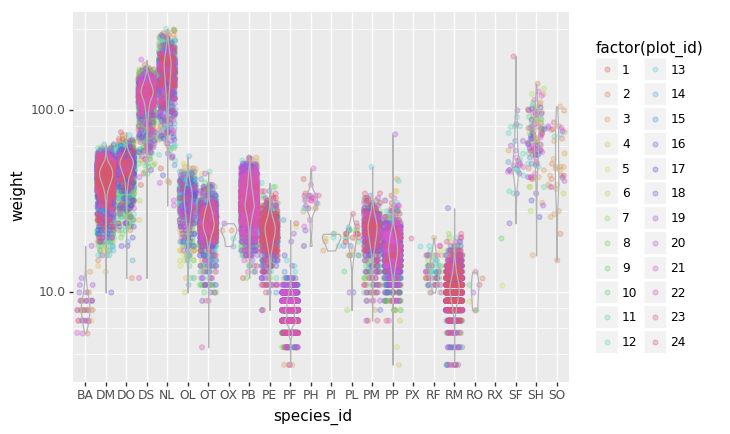

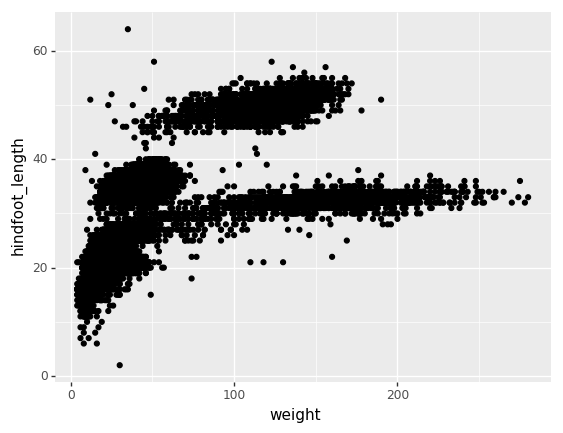

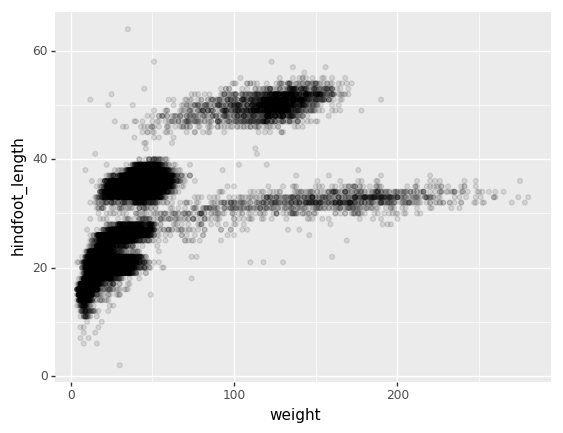

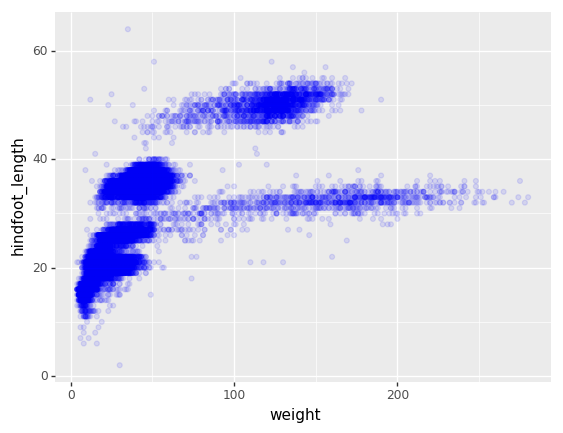

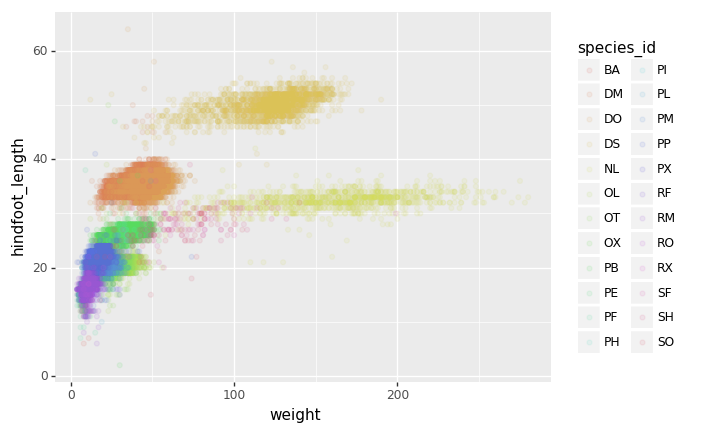

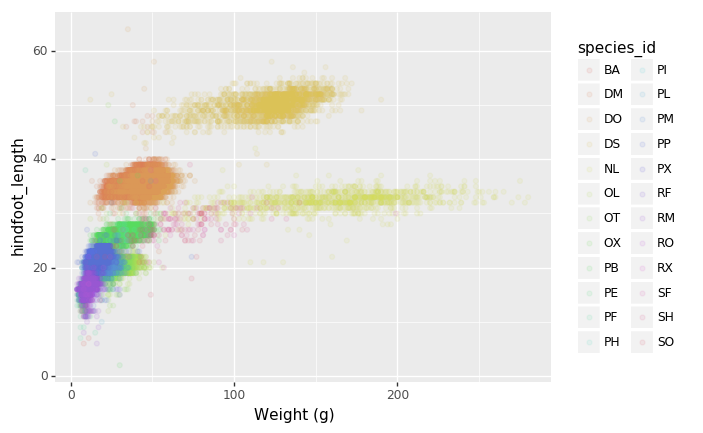

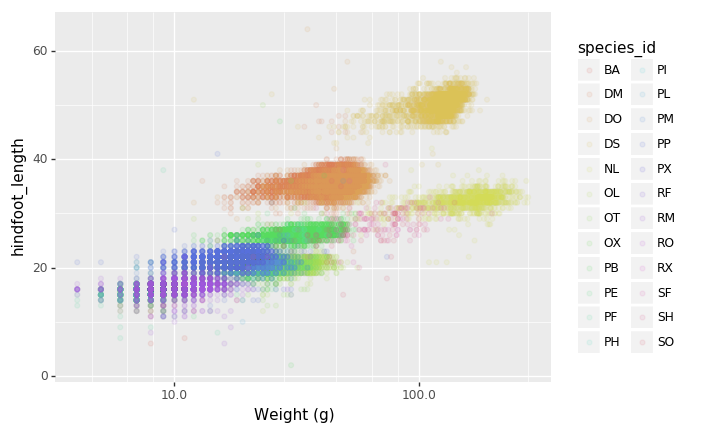

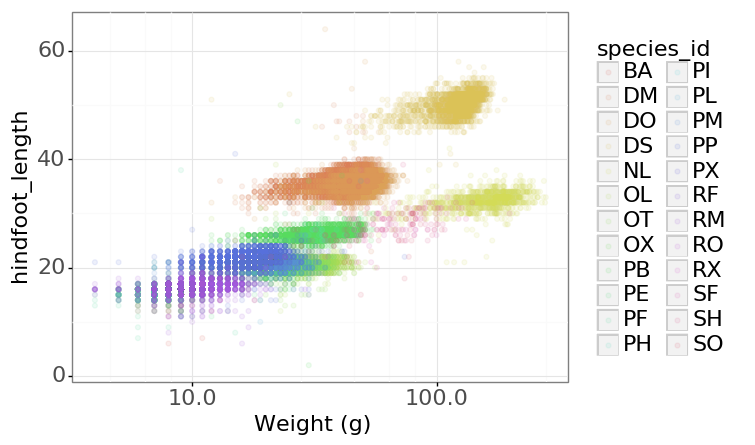

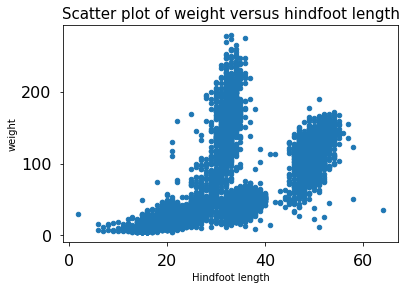

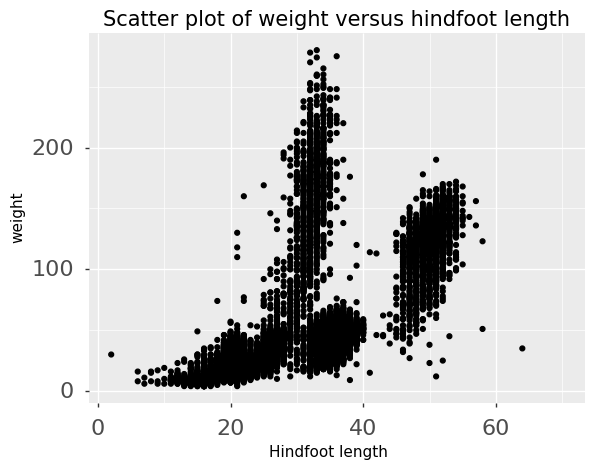

Graficar rápida y fácilmente los datos usando Pandas

También podemos gráficar nuestras estadísticas descriptivas usando Pandas.

PYTHON

# Aseguremonos de que las imágenes aparezcan insertadas en iPython Notebook

%matplotlib inline

# Creaemos una gráfica de barras

species_counts.plot(kind='bar'); Conteos de especie por sitio

Conteos de especie por sitio

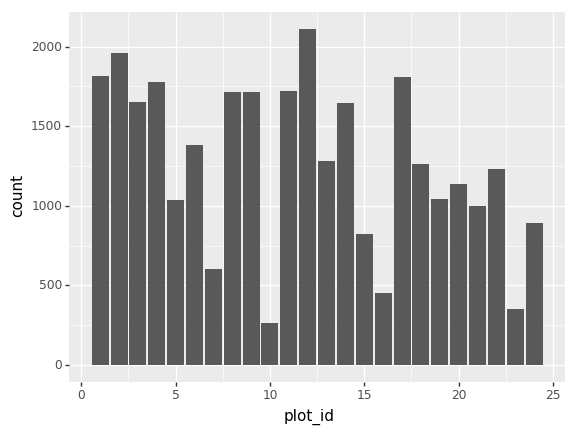

También podemos ver cuantos animales fueron capturados por sitio:

PYTHON

total_count = surveys_df.groupby('plot_id')['record_id'].nunique()

# También grafiquemos eso

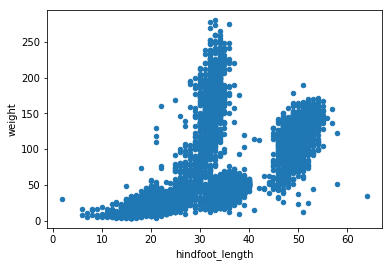

total_count.plot(kind='bar');Reto - Gráficas

- Crea una gráfica del promedio de peso de las especies por sitio.

- Crea una gráfica del total de machos contra el total de hembras para todo el conjunto de datos.

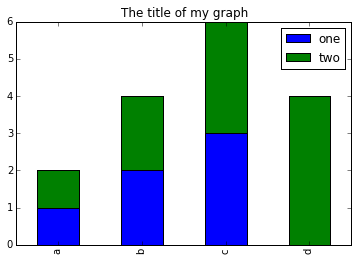

Reto de graficación final

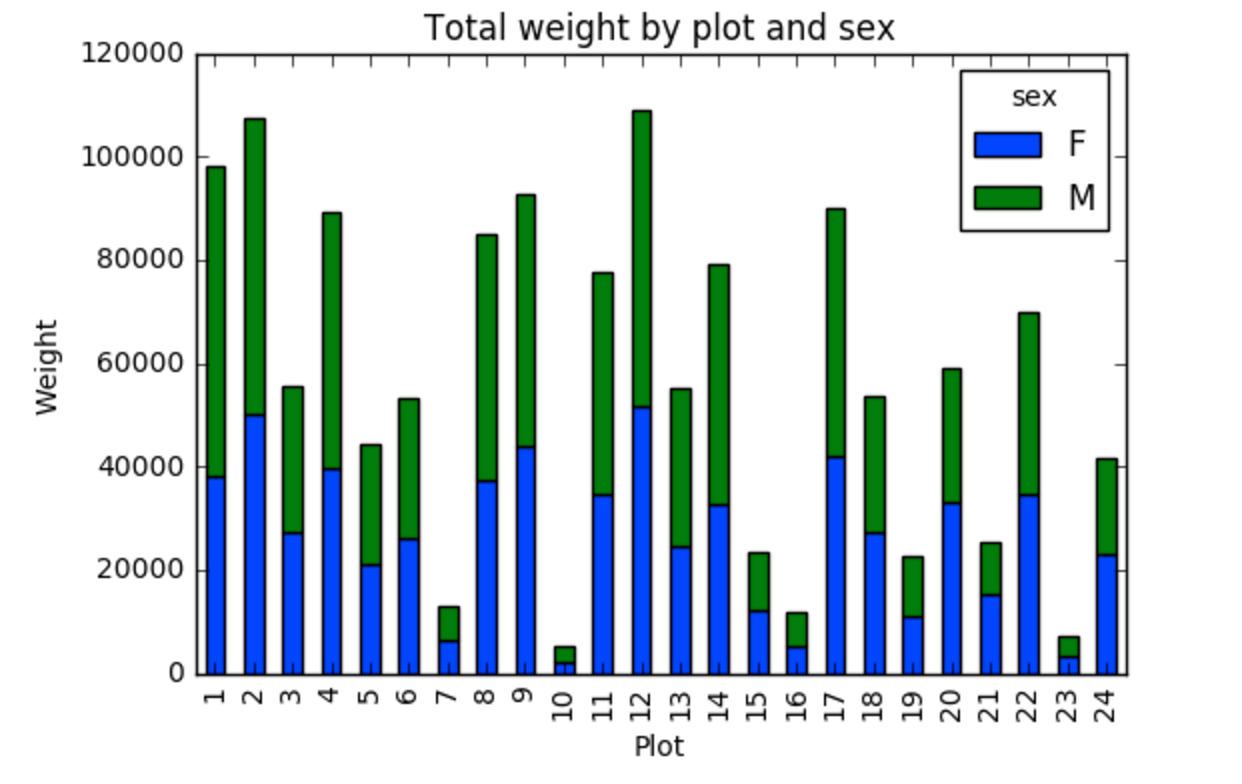

Crea una gráfica de barras apiladas con el peso en el eje Y, y la variable de apilamiento que sea el sexo. La gráfica debe mostrar el peso total por sexo para cada sitio. Algúnos tips que te pueden ayudar a resolver el reto son los siguientes:

- Para mayor información en gráfica con Pandas, visita la siguiente liga.

- Puedes usar el siguiente código para crear una gráficad de barras apiladas pero los datos para apilar deben de estar en distintas columnas. Aquí hay un pequeño ejemplo con algunos datos donde ‘a’, ‘b’ y ‘c’ son los grupos, y ‘one’ y ‘two’ son los subgrupos.

PYTHON

d = {'one' : pd.Series([1., 2., 3.], index=['a', 'b', 'c']),'two' : pd.Series([1., 2., 3., 4.], index=['a', 'b', 'c', 'd'])}

pd.DataFrame(d)muestra los siguientes datos

SALIDA

one two

a 1 1

b 2 2

c 3 3

d NaN 4Podemos gráficar esto con

PYTHON

# Graficar datos apilados de modo que las columnas 'one' y 'two' estén apiladas

my_df = pd.DataFrame(d)

my_df.plot(kind='bar',stacked=True,title="The title of my graph")

- Podemos usar el método

.unstack()para transformar los datos agrupados en columnas para cada gráfica. Intenta ejecutar.unstack()en algún DataFrame anterior y observa a que lleva.

Empieza transformando los datos agrupados (por sitio y sexo) en una disposición desapilada entonces crea una gráfica apilada.

Primero agrupemos los datos por sitio y por sexo y después calculemos el total para cada sitio.

PYTHON

by_site_sex = surveys_df.groupby(['plot_id','sex'])

site_sex_count = by_site_sex['weight'].sum()Esto calcula la suma de los pesos para cada sexo por sitio como una tabla

SALIDA

site sex

plot_id sex

1 F 38253

M 59979

2 F 50144

M 57250

3 F 27251

M 28253

4 F 39796

M 49377

<lo demás fue omitido para abreviar>Ahora usaremos .unstack() en los datos agrupados para

entender como el peso total de cada sexo contribuye a cada sitio.

PYTHON

by_site_sex = surveys_df.groupby(['plot_id','sex'])

site_sex_count = by_site_sex['weight'].sum()

site_sex_count.unstack()El método unstack de arriba despliega la siguiente

salida:

SALIDA

sex F M

plot_id

1 38253 59979

2 50144 57250

3 27251 28253

4 39796 49377

<los demás sitios son omitido por brevedar>Ahora creamos una gráfica de barras apilada con los datos donde el peso para cada sexo es apilado por sitio.

En vez de mostrarla como tabla, nosotros podemos graficar los datos apilando los datos de cada sexo como sigue:

PYTHON

by_site_sex = surveys_df.groupby(['plot_id','sex'])

site_sex_count = by_site_sex['weight'].sum()

spc = site_sex_count.unstack()

s_plot = spc.plot(kind='bar',stacked=True,title="Total weight by site and sex")

s_plot.set_ylabel("Weight")

s_plot.set_xlabel("Plot")

- Las bibliotecas en Python son conjuntos de herramientas, funciones y estructuras de datos, agrupadas de forma conveniente para facilitar nuestro trabajo.

- Pandas es una librería que ofrece funcionalidades avanzadas para manejar datos tabulares, procesarlos y obtener resultados similares a los que ofrecen las hojas de cálculo.

- El DataFrame es la estructura de datos fundamental de Pandas, representa una tabla de datos panel con indexación integrada. Cada columna contiene los valores de una variable y cada fila un conjunto de valores de cada columna.

- Un índice es un vector inmutable, ordenado y divisible, que almacena las etiquetas de los ejes de todas las estructuras de Pandas. Se utiliza para agrupar y seleccionar de distintas maneras el contenido de un DataFrame.

- Pandas ofrece funcionalidades que permiten realizar operaciones matemáticas, calcular estadísticas y generar gráficos a partir del contenido de una Serie o DataFrame.

Content from Indexación, segmentación y creación de subconjuntos a partir de DataFrames en Python

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 60 minutos

En la lección 01, leímos un archivo CSV y cargamos los datos en un pandas DataFrame. Aprendimos:

Hoja de ruta

Preguntas

- ¿Cómo puedo acceder a un dato específico en mi ‘dataset’?

- ¿Cómo pueden ayudarme Python y Pandas a analizar mis datos?

Objetivos

- Describir que es indexación en base-0.

- Manipular y extraer datos usando encabezados de columnas e índices.

- Usar ‘slicing’ para seleccionar conjuntos de datos de un ‘DataFrame’.

- Emplear etiquetas e índices enteros para seleccionar rangos de datos en un ‘DataFrame’.

- Reasignar valores dentro de subconjuntos de datos de un ‘DataFrame’.

- Crear una copia de un ‘DataFrame’.

- Consultar/Seleccionar un subconjunto de datos usando un conjunto de criterios utilizando los siguientes operadores: =, !=, >, <, >=, <=.

- Localizar subconjuntos de datos utilizando máscaras.

- Describir objetos tipo ‘boolean’ en Python y manipular datos usando ‘booleans’.

- como guardar el DataFrame en un objeto,

- como realizar operaciones matemáticas básica sobre datos,

- como calcular resúmenes estadísticos, y

- como crear gráficos a partir de los datos.

En esta lección, exploraremos formas de acceder a diferentes partes de los datos usando:

- indexación,

- segmentación, y

- creación de subconjuntos.

Cargando nuestros datos

Vamos a continuar usando el dataset surveys que usamos con la lección anterior. Reabrámoslo y leamos los datos de nuevo:

Indexando y Fragmentando en Python

A menudo necesitamos trabajar con subconjuntos de un objeto DataFrame. Existen diferentes maneras de lograr esto, incluyendo: usando etiquetas (encabezados de columnas), rangos numéricos, o índices de localizaciones específicas x,y.

Seleccionando datos mediante el uso de Etiquetas (Encabezados de Columnas)

Utilizamos corchetes [] para seleccionar un subconjunto

de un objeto en Python. Por ejemplo, podemos seleccionar todos los datos

de una columna llamada species_id del

surveys_df DataFrame usando el nombre de

la columna. Existen dos maneras de hacer esto:

PYTHON

# Sugerencia: usa el método .head() que vimos anteriormente para hacer la salida más corta

# Método 1: selecciona un 'subconjunto' de los datos usando el nombre de la columna

surveys_df['species_id']

# Método 2: usa el nombre de la columna como un 'atributo'; esto produce la misma salida

surveys_df.species_idTambién podemos crear un nuevo objeto que contiene solamente los

datos de la columna species_id de la siguiente manera:

PYTHON

# Crea un objeto, `surveys_species`, que solamente contenga la columna `species_id`

surveys_species = surveys_df['species_id']También podemos pasar una lista de nombres de columnas, a manera de índice para seleccionar las columnas en ese orden. Esto es útil cuando necesitamos reorganizar nuestros datos.

NOTA: Si el nombre de una columna no esta incluido

en el DataFrame, se producirá una excepción (error).

PYTHON

# Selecciona las especies y crea un gráfico con las columnas del **DataFrame**

surveys_df[['species_id', 'plot_id']]

# ¿Qué pasa cuando invertimos el orden?

surveys_df[['plot_id', 'species_id']]

# ¿Qué pasa si preguntamos por una columna que no existe?

surveys_df['speciess']Python nos informa que tipo de error es en el rastreo, en la parte

inferior dice KeyError: 'speciess' lo que significa que

speciess no es un nombre de columna (o Key

que está relacionado con el diccionario de tipo de datos de Python).

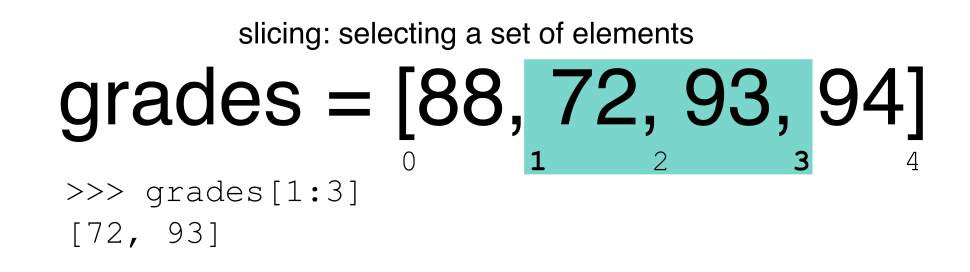

Extrayendo subconjuntos basados en rangos: Segmentando

RECORDATORIO: Python usa Indexación en base-0

Recordemos que Python usa indexación en base-0. Esto quiere decir que el primer elemento en un objeto esta localizado en la posición 0. Esto es diferente de otros lenguajes como R y Matlab que indexan elementos dentro de objetos iniciando en 1.

Segmentando Subconjuntos de Filas en Python

La segmentación utilizando el operador [] selecciona un

conjunto de filas y/o columnas de un DataFrame. Para

segmentar un conjunto de filas, usa la siguiente sintaxis:

data[start:stop]. Cuando se hace segmentación en pandas, el

límite inicial (start) se incluye en los datos de

salida. El límite final (stop) es un paso MÁS ALLÁ de

la fila que desea seleccionar. Así que si deseas seleccionar las filas

0, 1 y 2, tu código se vería así:

El límite final en Python es diferente del que puedes estar acostumbrado a usar en Lenguajes como Matlab y R.

PYTHON

# Selecciona las primeras cinco filas (con índices 0, 1, 2, 3, 4)

surveys_df[:5]

# Selecciona el último elemento de la lista

# (el segmento comienza en el último elemento y finaliza al final de la lista)

surveys_df[-1:]También podemos reasignar valores dentro de subconjuntos de nuestro DataFrame.

Pero antes de hacerlo, veamos la diferencia entre el concepto de copiar objetos y el concepto de referenciar objetos en Python.

Copiar Objetos vs Referenciar Objetos en Python

Empecemos con un ejemplo:

PYTHON

# Usando el método 'copy()'

true_copy_surveys_df = surveys_df.copy()

# Usando el operador '='

ref_surveys_df = surveys_dfPuedes pensar que el código ref_surveys_df = surveys_df

crea una copia nueva y distinta de objeto DataFrame

surveys_df. Sin embargo, usar el operador = en

una instrucción simple de la forma y = x

no crea una copia de nuestro

DataFrame. En lugar de esto, y = x crea

una variable nueva y que hace referencia al

mismo objeto al que x hace referencia.

Para decirlo de otra manera, solamente hay un objeto

(el DataFrame), y ambos objetos x y

y hacen referencia a él.

En contraste, el método copy() de un

DataFrame crea una copia verdadera del

DataFrame.

Veamos lo que sucede cuando reasignamos los valores dentro de un subconjunto del DataFrame que hace referencia a otro objeto DataFrame:

PYTHON

# Asigna el valor `0` a las primeras tres filas de datos en el **DataFrame**

ref_surveys_df[0:3] = 0Probemos el siguiente código:

PYTHON

# ref_surveys_df fue creado usando el operador '='

ref_surveys_df.head()

# surveys_df es el **DataFrame** original

surveys_df.head()¿Cuál es la diferencia entre estos dos DataFrames?

Cuando asignamos a las tres primeras filas el valor de 0

usando el DataFrame ref_surveys_df, el

DataFrame surveys_df también es

modificado. Recuerda que creamos el objeto ref_survey_df

arriba usando la instrucción ref_survey_df = surveys_df.

Por lo tanto surveys_df y ref_surveys_df hacen

referencia exactamente al mismo objeto DataFrame. Si

cualquiera de los dos objetos (ref_survey_df,

surveys_df) es modificado, el otro objeto va a observar los

mismos cambios.

Revisar y Recapitular:

-

Para crear una copia de un objeto, usamos el método copy() de un

DataFrame -

Para crear una referencia a un objeto usamos el operador

=

Muy bien, hora de practicar. Vamos a crear un nuevo objeto

DataFrame a partir del archivo CSV con los datos

originales.

Segmentando subconjuntos de filas y columnas en Python

Podemos seleccionar subconjuntos de datos, contenidos en rangos específicos de filas y columnas, usando etiquetas o indexación basada en números enteros.

-

loces usado principalmente para indexación basada en etiquetas. Permite usar números enteros pero son interpretados como una etiqueta. -

iloces usado para indexación basada en números enteros

Para seleccionar un subconjunto de filas y columnas

de nuestro objeto DataFrame, podemos usar el método

iloc. Por ejemplo, podemos seleccionar month,

day y year (que corresponden a las columnas 2,

3 y 4, si empezamos a contar las columnas en 1) para las primeras tres

filas, de la siguiente manera:

lo cual nos produce la siguiente salida

SALIDA

month day year

0 7 16 1977

1 7 16 1977

2 7 16 1977Ten en cuenta que pedimos un segmento de 0:3. Esto produjo 3 filas de datos. Cuando pides un segmento de 0:3, le estas diciendo a Python que comience en el índice 0 y seleccione las filas 0, 1, 2, hasta 3 pero sin incluir esta última.

Exploremos otras maneras de indexar y seleccionar subconjuntos de datos:

PYTHON

# Selecciona todas las columnas para las filas con índices entre 0 y 10

surveys_df.loc[[0, 10], :]

# ¿Qué salida produce el la siguiente instrucción?

surveys_df.loc[0, ['species_id', 'plot_id', 'weight']]

# ¿Qué pasa cuando ejecutas el siguiente código?

surveys_df.loc[[0, 10, 35549], :]NOTA: Las etiquetas utilizadas deben estar incluidas

en el DataFrame o se obtendrá un error de tipo

KeyError.

La indexación por etiquetas (loc) difiere de la

indexación por números enteros (iloc). Cuando usamos

loc, los limites inicial y final se

incluyen. Cuando usamos loc,

podemos usar números enteros, pero dichos números enteros harán

referencia a etiquetas usadas a manera de índice y no a la posición. Por

ejemplo, si usamos loc y seleccionamos 1:4 vamos a obtener

resultados diferentes que si usamos iloc para seleccionar

las filas 1:4.

Podemos seleccionar un dato específico utilizando la la intersección

de una fila y una columna dentro del DataFrame, junto con

la indexación basada en números enteros iloc:

PYTHON

# Sintaxis para encontrar un dato especifico dentro de un `DataFrame` utilizando indexación `iloc`

dat.iloc[fila, columna]En este ejemplo de iloc,

la salida es la siguiente

SALIDA

'F'Recuerda que la indexación en Python inicia en 0. Así que, la

direccíon basada en índice [2, 6] selecciona el elemento ubicado en la

intersección de la tercera fila (índice 2) y la séptima columna (índice

6) en el DataFrame.

Desafío - Rangos

- ¿Qué ocurre al ejecutar el siguiente código?:

surveys_df[0:1]surveys_df[:4]surveys_df[:-1]

- ¿Qué pasa al ejecutar este otro?:

dat.iloc[0:4, 1:4]dat.loc[0:4, 1:4]¿Qué diferencia observas entre los resultados de los comandos inmediatamente anteriores?

Creando subconjuntos de datos mediante el filtrado por criterios

También podemos seleccionar un subconjunto de nuestros datos,

mediante el filtrado de la data original, usando algún criterio. Por

ejemplo, podemos seleccionar todas las filas que tienen el valor de 2002

en la columna year:

Lo cual produce la siguiente salida:

PYTHON

record_id month day year plot_id species_id sex hindfoot_length weight

33320 33321 1 12 2002 1 DM M 38 44

33321 33322 1 12 2002 1 DO M 37 58

33322 33323 1 12 2002 1 PB M 28 45

33323 33324 1 12 2002 1 AB NaN NaN NaN

33324 33325 1 12 2002 1 DO M 35 29

...

35544 35545 12 31 2002 15 AH NaN NaN NaN

35545 35546 12 31 2002 15 AH NaN NaN NaN

35546 35547 12 31 2002 10 RM F 15 14

35547 35548 12 31 2002 7 DO M 36 51

35548 35549 12 31 2002 5 NaN NaN NaN NaN

[2229 rows x 9 columns]También podemos seleccionar todas las filas que no contienen el año 2002:

También podemos definir conjuntos de criterios:

Hoja de referencia para sintaxis de Python

Podemos utilizar la sintaxis incluida a continuación, cuando queramos

hace consultas de datos por criterios en un DataFrame.

Experimenta seleccionando varios subconjuntos de los datos contenidos en

surveys_df.

- Igual a:

== - No igual o diferente de:

!= - Mayor que, menor que:

>or< - Mayor o igual que

>= - Menor o igual que

<=

Desafío - Consultas

Selecciona un subconjunto de filas, en el

DataFramesurveys_df, que contenga datos desde el año 1999 y que contenga valores enweightmenores o iguales a 8. ¿Cuántas filas obtuviste como resultado? ¿Cuántas filas obtuvo tu compañera?Puedes usar la función

isinde Python para hacer una consulta a unDataFrame, basada en una lista de valores según se muestra a continuación:

Usa la función isin para encontrar todos los

plots que contienen una especie en particular en el

DataFrame surveys_df. ¿Cuántos registros

contienen esos valores?

Experimenta con otras consultas. Crea una consulta que encuentre todas las filas con el valor de

weightmayor o igual a 0.El símbolo

~puede ser usado en Python para obtener lo opuesto a los datos seleccionados que hayas especificado. Es equivalente a no esta en. Escribe una consulta que seleccione todas las filas consexdiferente de ‘M’ o ‘F’ en los datos desurveys_df.

Usando máscaras para identificar una condición específica

Una máscara puede ser útil para identificar donde

existe o no exite un subconjunto específico de valores - por ejemplo,

NaN, o Not a Number en inglés. Para enternder el

concepto de máscaras, también tenemos que entender los objetos

BOOLEAN en Python.

Valores boleanos (boolean) incluyen

True o False. Por ejemplo,

PYTHON

# Asigna 5 a la variable x

x = 5

# ¿Qué nos devuelve la ejecución del siguiente código?

x > 5

# ¿Qué nos devuelve la ejecución de este?

x == 5Cuando le preguntamos a Python ¿Cuál es el valor de

x > 5?, obtenemos False. Esto se debe a que

la condición x es mayor que 5, no se cumple dado que

x es igual a 5.

Para crear una máscara booleana:

- Establece el criterio a ser evaluado como

TrueoFalse(ej.values > 5 = True) - Python evaluará cada valor en el objeto para determinar si el valor

cumple el criterio (

True) o no lo cumple (False). - Python crea un objeto de salida que es de la misma forma que el

objeto original, pero con un valor

TrueoFalsepor cada índice según corresponda.

Intentémoslo. Vamos a identificar todos los lugares en los datos de

survey que son null (que no existen o son

NaN). Podemos usar el método isnull para lograrlo. El

método isnull va a comparar cada celda con un valor

null. Si un elemento tiene un valor null, se

le asignará un nuevo valor de True en el objeto de

salida.

Un fragmento de la salida se muestra a continuación:

PYTHON

record_id month day year plot_id species_id sex hindfoot_length weight

0 False False False False False False False False True

1 False False False False False False False False True

2 False False False False False False False False True

3 False False False False False False False False True

4 False False False False False False False False True

[35549 rows x 9 columns]Para seleccionar las filas donde hay valores null,

podemos utilizar una máscara a manera de índice y obtener subconjuntos

de datos así:

PYTHON

# Para seleccionar solamente las filas con valores NaN, podemos utilizar el método 'any()'

surveys_df[pd.isnull(surveys_df).any(axis=1)]Nota que la columna weight de nuestro

DataFrame contiene varios valores null o

NaN. Exploraremos diferentes maneras de abordar esto en el

episodio de tipos

de datos y formatos.

También podemos utilizar isnull en una columna en

particular. ¿Qué salida produce el siguiente código?

PYTHON

# ¿Qué hace el siguiente código?

empty_weights = surveys_df[pd.isnull(surveys_df['weight'])]['weight']

print(empty_weights)Tomemos un minuto para observar las instrucciones de arriba. Estamos

usando el objeto booleano pd.isnull(surveys_df['weight']) a

manera de índice para surveys_df. Estamos pidiendo a Python

que seleccione aquellas filas que tienen un valor de NaN en

la columna weight.

Desafío - Revisando todo lo aprendido

Crea un nuevo objeto

DataFrameque solamente contenga observaciones cuyos valores en la columnasexno seanfemaleomale. Asigna cada valor desexen el nuevoDataFramea un nuevo valor de ‘x’. Determina el número total de valoresnullen el subconjunto.Crea un nuevo objeto

DataFrameque contenga solo observaciones cuyos valores en la columnasexseanmaleofemaley en los cuales el valor deweightsea mayor que 0. Luego, crea un gráfico de barra apiladas del promedio deweight, por parcela, con valoresmaleversusfemaleapilados por cada parcela.

- En Python, fragmentos de datos pueden ser accedidos usando índices, cortes, encabezados de columnas, y subconjuntos basados en condiciones.

- Python usa indexación base-0, en la cual el primer elemento de una lista, tupla o cualquier otra estructura de datos tiene un índice de 0.

- ‘Pandas’ permite usar procedimientos comunes de exploración de datos como indexación de datos, cortes y creación de subconjuntos basados en condiciones.

Content from Tipos de datos y formatos

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 45 minutos

El formato de columnas y filas individuales afectará el análisis realizado en un dataset leído en Python. Por ejemplo, no se pueden realizar cálculos matemáticos sobre una secuencia de caracteres (datos con formato de texto). Esto puede parecer obvio, sin embargo, a veces en Python los valores numéricos son leídos como secuencias de caracteres. En esta situación, cuando intentas realizar cálculos con datos numéricos sobre datos formateados como secuencias de caracteres, obtienes un error.

Hoja de ruta

Preguntas

- ¿Qué tipos de datos pueden estar contenidos en un DataFrame?

- ¿Por qué es importante el tipo de datos?

Objetivos

- Describir cómo se almacena la información en un DataFrame de Python.

- Examinar la estructura de un DataFrame.

- Modificar el formato de los valores en un DataFrame.

- Describir cómo los tipos de datos afectan a las operaciones.

- Definir, manipular e interconvertir integers y floats en Python.

- Analizar datasets que tienen valores faltantes/nulos (valores NaN).

- Escribir datos manipulados a un archivo.

En esta lección repasaremos maneras de explorar y comprender mejor la estructura y formato de nuestros datos.

Tipos de Datos

La forma en que se almacena la información en un DataFrame u objeto Python afecta a lo que podemos hacer con él y también a los resultados de los cálculos. Hay dos tipos principales de datos que estaremos explorando en esta lección: tipos de datos numéricos y de texto.

Tipos de Datos Numéricos

Los tipos de datos numéricos incluyen enteros

(integer) y números de punto flotante

(float). Un número de punto flotante tiene puntos

decimales incluso si el valor del punto decimal es 0. Por ejemplo: 1.13,

2.0, 1234.345. Si tenemos una columna que contiene tanto enteros como

números de punto flotante, Pandas asignará el tipo de dato

float a toda la columna, de modo tal que los puntos

decimales no se pierdan.

Un integer nunca tendrá un punto decimal. Así que,

si quisiéramos almacenar 1.13 como un entero de tipo

integer se almacenará como 1. Del mismo modo, 1234.345

se almacenará como 1234. A menudo, en Python verás el tipo de dato

Int64 que representa un entero de 64 bits. El 64

simplemente se refiere a la memoria asignada para almacenar datos en

cada celda; eso se refiere a la cantidad de dígitos que puede

efectivamente almacenar cada “celda”. Asignar espacio antes de tiempo

permite a las computadoras optimizar el almacenamiento y hacer más

eficiente el procesamiento.

Tipo de Datos de Texto

En Python, el tipo de datos de texto se conoce como secuencia de caracteres (string). En Pandas se los conoce como objetos (object). Las secuencias de caracteres pueden contener números y / o caracteres. Por ejemplo, una secuencia de caracteres puede ser una palabra, una oración, o varias oraciones. Un objeto Pandas también podría ser un nombre de gráfico como ‘plot1’. Una secuencia de caracteres también puede contener o consistir en números. Por ejemplo, ‘1234’ podría ser almacenado como una secuencia de caracteres. También ‘10.23’ podría ser almacenado como secuencia de caracteres. Sin embargo, ¡las las secuencias de caracteres que contienen números no se pueden utilizar en operaciones matemáticas!

Pandas y Python básico utilizan nombres ligeramente diferentes para los tipos de datos. Más sobre esto en la tabla de abajo:

| Tipo en Pandas | Tipo en Python Nativo | Descripción |

|---|---|---|

| object | string | El dtype más general. Será asignado a tu columna si la columna contiene tipos mixtos (números y secuencias de caracteres). |

| int64 | int | Caracteres numéricos. 64 se refiere a la memoria asignada para almacenar el caracter. |

| float64 | float | Caracteres numéricos con decimales. Si una columna contiene números y NaNs (ver más abajo), Pandas usará float64 por defecto, en caso de que los datos faltantes contengan decimales. |

| datetime64, timedelta[ns] | N/D (ver el módulo datetime en la biblioteca estandar de Python) | Valores destinados a contener datos de tiempo. Mira en estos para experimentos con series de tiempo. |

Comprobando el formato de nuestros datos

Ahora que tenemos una comprensión básica de los tipos de datos

numéricos y de texto, exploremos el formato de los datos de nuestra

encuesta. Estaremos trabajando con el mismo dataset

surveys.csv que hemos usado en lecciones anteriores.

PYTHON

# Ten en cuenta que se usa `pd.read_csv` porque importamos pandas con el alias `pd`

surveys_df = pd.read_csv ("data/surveys.csv")Recuerda que podemos comprobar el tipo de un objeto de la siguiente manera:

OUTPUT: pandas.core.frame.DataFrame

A continuación, veamos la estructura de datos de nuestras encuestas.

En pandas, podemos comprobar el tipo de datos de una columna en un

DataFrame usando la sintaxis

dataFrameName[column_name].dtype:

OUTPUT: dtype('O')

Un tipo ‘O’ solo significa “objeto” que en el mundo de Pandas es una secuencia de caracteres (texto).

OUTPUT: dtype('int64')

El tipo int64 nos dice que Python está almacenando cada

valor dentro de esta columna como un entero de 64 bits. Podemos usar el

comando dat.dtypes para ver el tipo de datos de cada

columna de un DataFrame (todos a la vez).

which returns:

PYTHON

record_id int64

month int64

day int64

year int64

plot_id int64

species_id object

sex object

hindfoot_length float64

weight float64

dtype: objectTen en cuenta que la mayoría de las columnas en nuestros datos de

encuesta son del tipo int64. Esto significa que son enteros

de 64 bits. Pero la columna de peso (weight) es un valor de punto

flotante o float, lo que significa que contiene decimales.

Las columnas species_id y sex son objetos, lo

cual significa que contienen secuencias de caracteres

string.

Trabajando con integers y floats

Así que hemos aprendido que las computadoras almacenan los números de

una de dos maneras: como enteros integer o como números de

punto flotante float. Los integers son los

números que usualmente usamos para contar. Los float

tienen parte fraccionaria (decimal). Consideremos ahora cómo el tipo de

datos puede impactar en las operaciones matemáticas entre nuestros

datos. La suma, la resta, la división y la multiplicación funcionan en

float e integer como es de

esperar.

Si dividimos un integer por otro, obtenemos un float. El resultado en Python 3 es diferente al de Python 2, donde el resultado es un integer (porque Python 2 hace una división entera).

También podemos convertir un número de punto flotante en un entero, o un entero en un número de punto flotante. Ten en cuenta que Python redondea por defecto cuando convierte de float a integer.

Trabajando con los datos de nuestra encuesta

Volviendo a nuestros datos, si lo deseamos, podemos modificar el

formato de los valores dentro de nuestros datos. Por ejemplo, podríamos

convertir el campo record_id a float

PYTHON

# Convertir el campo record_id de integer a float

surveys_df['record_id'] = surveys_df['record_id'].astype('float64')

surveys_df['record_id'].dtypeOUTPUT: dtype('float64')

Desafío - Cambiando tipos

Intenta convertir la columna

plot_ida float usandoA continuación, intenta convertir

weight(peso) en un integer. ¿Qué te dice Pandas? ¿Qué es lo que va mal ahí? Más adelante, hablaremos acerca de algunas soluciones a esto.

Valores de datos faltantes o nulos - NaN

¿Qué ocurrió en en el desafío? Ten en cuenta que esto arroja un error de valor:

ValueError: Cannot convert NA to integer.

Si observamos la columna weight (peso) de los datos de

las encuestas, notamos que hay valores NaN (Not

a Number) (no es número). Los valores

**NaN ** son valores que no están definidos y que no se pueden

representar matemáticamente. Pandas, por ejemplo, leerá como NaN

aquellas celdas vacías de una hoja CSV o Excel. Los valores NaN tienen

algunas propiedades deseables: si tuviéramos que promediar la columna

weight (peso) sin reemplazar los valores NaN, Python sabría

saltarse las celdas vacías.

Tratar con valores de datos faltantes siempre es un desafío. A veces es dificil saber por qué faltan valores. ¿Fue debido a un error de entrada de datos? ¿O son datos que alguien no pudo recoger? ¿Debe considerarse el valor como 0? Para tomar buenas decisiones, necesitamos saber qué representan los valores faltantes del dataset. Si tenemos suerte, tendremos algunos metadatos que nos dirán más acerca de cómo fueron manejados los valores nulos.

Por ejemplo, en algunas disciplinas, como el sensado remoto, los valores de datos faltantes suelen definirse como -9999. Tener un montón de valores -9999 en tus datos podría realmente alterar los cálculos numéricos. A menudo, en las hojas de cálculo, las celdas se dejan vacías cuando no hay datos disponibles. Por defecto, Pandas reemplazará esos valores nulos con NaN. Sin embargo, es una buena práctica adquirir el hábito de marcar intencionalmente aquellas celdas que no tienen datos con un valor que represente “sin datos”! De esa manera, en el futuro, no habrá preguntas cuando tu (o alguna otra persona) explore los datos.

¿Dónde están los NaN’s?

Exploremos un poco más los valores NaN en nuestros datos. Usando las herramientas que hemos aprendido en la lección 02, podemos averiguar cuántas filas contienen valores NaN en la columna weight (peso). También, partiendo de nuestros datos, podemos crear un nuevo subconjunto que contenga solamente aquellas filas con peso mayor a cero (es decir, seleccionar valores significativos de peso):

PYTHON

len(surveys_df[pd.isnull(surveys_df.weight)])

# How many rows have weight values?

len(surveys_df[surveys_df.weight> 0])Usando el método .fillna () podemos reemplazar todos los

valores NaN por ceros (después de hacer una copia de

los datos de modo tal de no perder nuestro trabajo):

PYTHON

df1 = surveys_df.copy()

# Completar todos los valores NaN con ceros

df1['weight'] = df1['weight'].fillna(0)Sin embargo, NaN y cero arrojan diferentes resultados en el análisis. El valor promedio resulta diferente cuando los valores NaN se reemplazan con cero, comparando cuando los valores de NaN son descartados o ignorados.

Podemos completar los valores NaN con cualquier valor que elijamos. El código de abajo completa todos los Valores NaN con un promedio de los pesos.

También podríamos elegir crear un subconjunto de datos, manteniendo solamente aquellas filas que no contienen valores NaN.

La clave es tomar decisiones conscientes acerca de cómo administrar los datos faltantes. Aquí es donde pensamos cómo se utilizarán nuestros datos y cómo estos valores afectarán las conclusiones científicas que se obtengan de los datos.

Python nos brinda todas las herramientas que necesitamos para dar cuenta de estos problemas. Solo debemos ser cautelosos acerca de cómo nuestras decisiones impactan en los resultados científicos.

Desafío - Contando

Cuenta el número de valores perdidos por columna. Sugerencia: el

método .count() te proporciona el número de observaciones

que no son NA por columna. Examina el método .isnull().

Escribiendo datos a CSV

Hemos aprendido a manipular datos para obtener los resultados deseados. Pero también hemos discutido acerca de mantener los datos que han sido manipulados separados de los datos sin procesar. Algo que podríamos estar interesados en hacer es trabajar solo con las columnas que tienen datos completos. Primero, recarguemos los datos para no mezclar todas nuestras manipulaciones anteriores.

A continuación, vamos a eliminar todas las filas que contienen

valores nulos. Usaremos el comando dropna. De forma

predeterminada, dropna elimina las columnas que contienen

valores nulos incluso para una sola fila.

Si ahora escribes df_na, deberías observar que el

DataFrame resultante tiene 30676 filas y 9 columnas,

mucho menos que las 35549 filas originales.

Ahora podemos usar el comando to_csv para exportar un

DataFrame a formato CSV. Ten en cuenta que el código

que se muestra a continuación por defector guardará los datos en el

directorio de trabajo en el que estamos parados. Podemos guardarlo en

otra carpeta agregando el nombre de la carpeta y una barra inclinada

antes del nombre del archivo:

df.to_csv('foldername/out.csv'). Usamos

index = False para que Pandas no incluya el número de

índice para cada fila.

Usaremos este archivo de datos más adelante en el taller. Revisa tu directorio de trabajo para asegurarte de que el CSV se haya guardado correctamente y que puedas abrirlo. Si lo deseas, intenta recuperarlo con Python para asegurarte de que se importa correctamente.

Resumen

Hemos aprendido:

- Cómo explorar los tipos de dato de las colummnas de un DataFrame

- Cómo cambiar el tipo de dato

- Qué son los valores NaN, cómo deberían representarse, y lo que eso significa para tu trabajo

- Cómo reemplazar los valores NaN si así lo quisieras

- Como usar

to_csvpara guardar en un archivo los datos manipulados.

- Pandas usa otros nombres para tipos de datos que Python, por

ejemplo:

objectpara datos textuales. - Una columna en un DataFrame sólo puede tener un tipo de datos.

- El tipo de datos de la columna de un DataFrame puede ser comprobado

usando

dtype. - Es necesario tomar decisiones conscientes sobre cómo manejar los datos faltantes.

- Un DataFrame puede ser guardado en un archivo CSV usando la función

to_csv.

Content from Combinando DataFrames con Pandas

Última actualización: 2023-02-07 | Mejora esta página

Tiempo estimado: 45 minutos

En muchas situations del “mundo real”, los datos que queremos usar

proceden de múltiples archivos. Frecuentemente necesitamos combinar

estos archivos en un uniquo DataFrame para analizar los

datos. El paquete pandas proporciona varios

métodos de combinar DataFrames incluyendo

merge y concat.

Hoja de ruta

Preguntas

- ¿Puedo trabajar con datos de diferentes fuentes?

- ¿Cómo puedo combinar datos de diferentes datasets?

Objetivos

- Combinar datos de varios diferentes archivos en un único DataFrame

usando

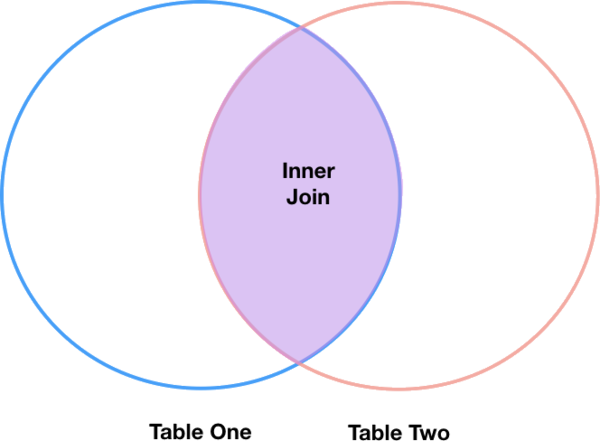

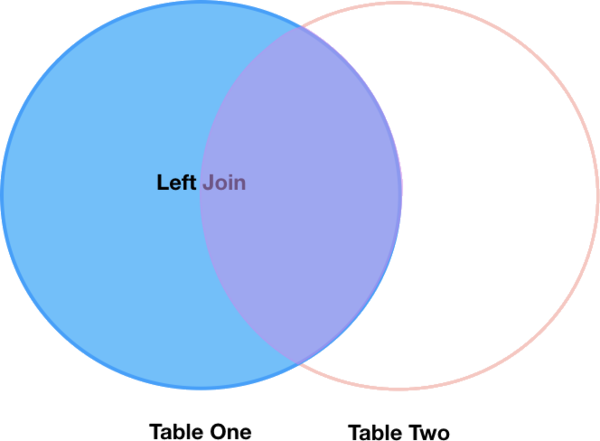

mergeyconcat. - Combinar dos DataFrames usando un ID único encontrado en ambos DataFrames.

- Unir DataFrames usando campos comunes (unión por claves).

Para trabajar en los ejemplos abajo, necesitamos primero cargar los archivos de species y surveys dentro de pandas DataFrames. En Python:

PYTHON

import pandas as pd

surveys_df = pd.read_csv("data/surveys.csv",

keep_default_na=False, na_values=[""])

surveys_df

record_id month day year plot species sex hindfoot_length weight

0 1 7 16 1977 2 NA M 32 NaN

1 2 7 16 1977 3 NA M 33 NaN

2 3 7 16 1977 2 DM F 37 NaN

3 4 7 16 1977 7 DM M 36 NaN

4 5 7 16 1977 3 DM M 35 NaN

... ... ... ... ... ... ... ... ... ...

35544 35545 12 31 2002 15 AH NaN NaN NaN

35545 35546 12 31 2002 15 AH NaN NaN NaN

35546 35547 12 31 2002 10 RM F 15 14

35547 35548 12 31 2002 7 DO M 36 51

35548 35549 12 31 2002 5 NaN NaN NaN NaN

[35549 rows x 9 columns]

species_df = pd.read_csv("data/species.csv",

keep_default_na=False, na_values=[""])

species_df

species_id genus species taxa

0 AB Amphispiza bilineata Bird

1 AH Ammospermophilus harrisi Rodent

2 AS Ammodramus savannarum Bird

3 BA Baiomys taylori Rodent

4 CB Campylorhynchus brunneicapillus Bird

.. ... ... ... ...

49 UP Pipilo sp. Bird

50 UR Rodent sp. Rodent

51 US Sparrow sp. Bird

52 ZL Zonotrichia leucophrys Bird

53 ZM Zenaida macroura Bird